Cronograma

lunes, 22 de abril de 2024

20:05

<<Cronograma_Procesamiento_Imagenes_Video_1C_2024_3.3.131.pdf>>

Apuntes

lunes, 22 de abril de 2024

18:43

Audio digital

lunes, 22 de abril de 2024

18:43

<<AES-EBU.pdf>>

<<AES-EBU

2.pdf>>

<<Psicoacústica

- Wikipedia.pdf>>

<<Psicoacústica

- Wikipedia.pdf>>

Compresion

lunes, 22 de abril de 2024

18:45

<<comdigtv.pdf>>

<<Digital

Video Broadcating.pdf>>

<<Estándar

de compresión de video H.264.pdf>>

<<Transformada

Wavelet.pdf>>

<<Presentación

TV Digital 2015.pdf>>

IPTV

lunes, 22 de abril de 2024

18:46

<<Streaming.pdf>>

<<Presentacion

Digital Media 2.pdf>>

<<Presentacion

TOC - NOC v3.pdf>>

Sistema Visual Humano

lunes, 22 de abril de 2024

20:00

<<SVH 1.pdf>>

<<SVH

2.pdf>>

<<SVH

3 - Percepcion visual, SVA.pdf>>

<<SVH

3 - Percepcion visual, SVA.pdf>>

<<SVH

4.pdf>>

<<5

- El ojo humano.pdf>>

<<IRI_ANATOMIA_BASICA_DEL_OJO_2003_.pdf>>

Señal de video

lunes, 22 de abril de 2024

20:05

<<La señal de video.pdf>>

<<La

señal de video 2.pdf>>

<<Sony

HDR Explained White Paper.pdf>>

Clases

lunes, 22 de abril de 2024

18:42

C1 - Introducción

lunes, 22 de abril de 2024

18:10

<<PIV_Clase_1_12032024.pdf>>

C2 - Colorimetria

lunes, 22 de abril de 2024

18:42

<<PIV_Clase_2_19032024.pdf>>

C3 - Captura de imagen

lunes, 22 de abril de 2024

18:42

<<PIV_Clase_3_26032024.pdf>>

C4 - VGA / Audio

lunes, 22 de abril de 2024

18:42

<<PIV_Clase_4_06042024.pdf>>

C5 - Muestreo

lunes, 22 de abril de 2024

18:42

<<PIV_Clase_5_09042024.pdf>>

C6 - Compresion / Formatos audio

lunes, 22 de abril de 2024

18:42

<<PIV_Clase_6_16042024.pdf>>

C7 - Compresion

lunes, 24 de junio de 2024

11:42

<<PIV_Clase_7_30042024.pdf>>

C8 - Jitter SDI + Transporte

lunes, 24 de junio de 2024

11:43

<<PIV_Clase_8_01052024.pdf>>

C10 - Transporte

lunes, 24 de junio de 2024

11:44

<<PIV_Clase_10_14052024.pdf>>

C11 - 3D

lunes, 24 de junio de 2024

11:44

<<PIV_Clase_11_21052024.pdf>>

C12 - Streaming

lunes, 24 de junio de 2024

11:45

<<PIV_Clase_12_28052024.pdf>>

C13 - Distribucion

lunes, 24 de junio de 2024

11:45

<<PIV_Clase_13_04062024.pdf>>

C14 - Distribucion

lunes, 24 de junio de 2024

11:45

<<PIV_Clase_14_11062024.pdf>>

Examenes

lunes, 22 de abril de 2024

20:14

Preguntas guia 1er Parcial

lunes, 22 de abril de 2024

20:14

- Que parte de la retina se excita más con los colores? Cual con la luminancia?

Conos y sensibilidad al color:

- Los conos son células fotorreceptoras especializadas en la retina que son responsables de la visión del color y la agudeza visual en condiciones de luz brillante.

- Hay tres tipos de conos, cada uno sensible a diferentes longitudes de onda de la luz: conos sensibles al rojo, al verde y al azul.

- La distribución de estos conos en la retina no es uniforme. Hay una mayor concentración de conos en la fóvea, que es el punto de máxima agudeza visual en el centro de la retina. Esto nos permite ver los detalles finos y distinguir los colores con precisión en el centro de nuestra visión.

- Los conos se activan de manera óptima cuando la luz que incide sobre ellos está en el rango de longitudes de onda a las que son más sensibles. Por ejemplo, los conos sensibles al rojo se activan más fuertemente por la luz roja, mientras que los conos sensibles al azul responden mejor a la luz azul.

Bastones y sensibilidad a la luminancia:

- Los bastones son otro tipo de células fotorreceptoras presentes en la retina, pero son más sensibles a la luz tenue y no son capaces de percibir los colores.

- A diferencia de los conos, los bastones son más abundantes en la periferia de la retina y son responsables de nuestra visión periférica y nuestra capacidad para ver en condiciones de baja luminosidad.

- Los bastones son más sensibles a la luminancia, que es la cantidad total de luz que llega a la retina, independientemente de su color. Esto significa que los bastones son cruciales para la visión en condiciones de poca luz, como durante el crepúsculo o en la oscuridad completa.

En resumen, los conos se especializan en la percepción del color y son más sensibles a diferentes longitudes de onda de la luz, mientras que los bastones son más sensibles a la luminancia y son esenciales para la visión en condiciones de baja luminosidad. Hay más bastones que conos.

- Que función cumple el nervio óptico?

El nervio óptico es una estructura crucial en el sistema visual humano, ya que transmite la información visual desde la retina hasta el cerebro. Su función principal es llevar las señales visuales generadas por los fotorreceptores en la retina hacia el cerebro, donde se procesa y se interpreta la información visual.

El nervio óptico está compuesto por fibras nerviosas que se originan en las células ganglionares de la retina. Estas células ganglionares recogen la información visual que ha sido procesada por los fotorreceptores (conos y bastones) y la transmiten a través del nervio óptico hacia el cerebro.

Una vez que las señales visuales llegan al cerebro a través del nervio óptico, se procesan en diferentes áreas visuales, como la corteza visual primaria en el lóbulo occipital, donde se interpretan y se genera la experiencia visual consciente.

En resumen, el nervio óptico actúa como un cable de comunicación esencial entre la retina y el cerebro, transmitiendo la información visual que luego se procesa para formar nuestra percepción visual del mundo que nos rodea.

- Que es el punto ciego?

El punto ciego, también conocido como mancha ciega, es un área en la retina donde el nervio óptico penetra en el ojo y donde no hay receptores de luz, es decir, no hay bastones ni conos. Como resultado, esta área no es capaz de detectar la luz y, por lo tanto, no puede formar una imagen visual.

Cada ojo tiene un punto ciego, y está ubicado aproximadamente 15 grados hacia afuera desde el centro de la retina. A pesar de que la retina es capaz de percibir una imagen completa del campo visual, el cerebro "rellena" la información faltante que proviene del punto ciego, utilizando la información visual de los alrededores para crear una imagen coherente del mundo.

Normalmente, no somos conscientes de nuestro punto ciego debido a la capacidad del cerebro para llenar los vacíos en la información visual. Sin embargo, se puede demostrar la existencia del punto ciego mediante una simple prueba de punto ciego, donde se hace que un objeto desaparezca cuando se encuentra en el área del punto ciego y luego vuelva a aparecer cuando se mueve fuera de él.

- Como se recrea la imagen?

La imagen visual se recrea en el cerebro a partir de la información que se recibe de la retina a través del nervio óptico y luego se procesa en diversas áreas visuales del cerebro.

El proceso de recrear la imagen visual en el cerebro involucra varias etapas:

- Transducción de la luz en señales eléctricas: En la retina, los fotorreceptores (conos y bastones) convierten la energía luminosa en señales eléctricas. Los conos son responsables de detectar el color y la luz brillante, mientras que los bastones son sensibles a la luz tenue y son esenciales para la visión nocturna.

- Transmisión de señales al cerebro: Las señales eléctricas generadas por los fotorreceptores viajan a través de las células bipolares y luego a las células ganglionares en la retina. Estas células ganglionares envían sus axones que se agrupan para formar el nervio óptico, que lleva las señales visuales al cerebro.

- Procesamiento en el cerebro: Una vez que las señales visuales llegan al cerebro, son procesadas en diferentes áreas visuales, como la corteza visual primaria en el lóbulo occipital. Aquí, las características de la imagen, como el color, la forma, el movimiento y la profundidad, son analizadas y combinadas para formar una representación visual coherente del mundo que nos rodea.

- Integración y percepción consciente: Las señales procesadas se integran con la información proveniente de otras áreas del cerebro, como la memoria y las emociones, para formar una percepción consciente de la imagen visual. Esta percepción visual nos permite interpretar y comprender el mundo que nos rodea, identificar objetos, reconocer rostros, y realizar actividades visuales complejas.

En resumen, la imagen visual se recrea en el cerebro a partir de la información visual que se recibe de la retina, y este proceso implica la transducción de la luz en señales eléctricas, la transmisión de señales al cerebro a través del nervio óptico, el procesamiento en diferentes áreas visuales del cerebro, y la integración y percepción consciente de la imagen visual.

- Por qué se produce la retención perceptiva del cerebro?

La retención perceptiva, también conocida como persistencia visual, es un fenómeno en el cual una imagen visual continúa siendo percibida por el cerebro incluso después de que la fuente de la imagen ya no esté presente. Este fenómeno se debe a la manera en que el sistema visual procesa e interpreta la información que recibe de la retina.

Existen dos tipos principales de retención perceptiva:

- Retención de imagen: Este tipo de retención perceptiva ocurre cuando una imagen visual es presentada durante un breve período de tiempo y luego se retira. El cerebro retiene la imagen por un corto período de tiempo después de que desaparece la fuente de la imagen. Este efecto es explotado en la animación y en el cine, donde una serie de imágenes estáticas se presentan rápidamente para crear la ilusión de movimiento.

- Retención de forma: Este tipo de retención perceptiva se refiere a la persistencia de la forma de un objeto visual después de que este ha desaparecido. Por ejemplo, si se muestra brevemente una imagen compleja y luego se retira, el cerebro puede seguir percibiendo los contornos o la forma general del objeto por un breve período de tiempo.

La retención perceptiva ocurre debido a la manera en que las células nerviosas en el sistema visual procesan y transmiten la información visual. Cuando se presenta una imagen visual, las células en la retina y en el cerebro se activan y envían señales eléctricas a lo largo de las vías visuales. Aunque la fuente de la imagen desaparezca, estas señales eléctricas continúan disparándose durante un breve período de tiempo, lo que resulta en la percepción continua de la imagen por parte del cerebro.

Este fenómeno es una característica fundamental del sistema visual humano y puede ser explotado en diversas formas, como en el diseño gráfico, la publicidad y el arte visual, para crear efectos visuales interesantes y cautivadores.

- Cálculo de muestreo de una señal, cantidad de pixeles, tamaño de pantalla, PPI

Resumen 2P

lunes, 24 de junio de 2024

11:53

Compresion

![]()

Normas

Video

- JPEG-2000

- MPEG-2 (H.262)

- MPEG-4 (H.264)

- MEVC (High Efficiency VideoCoding) (H.265)

Audio

- MPEG

- LI

- LII

- LIII (mp3)

- Dolby AC3

- AAC (Advanced Audio Compresion)

Eficiencia y delay

|

|

|

Delay |

R |

|

MPEG-2 |

24 Mbps |

<1s |

62 |

|

MPEG-4 |

15 Mbps |

4s |

99 |

|

HVEC |

8 Mbps |

6s |

185 |

PES

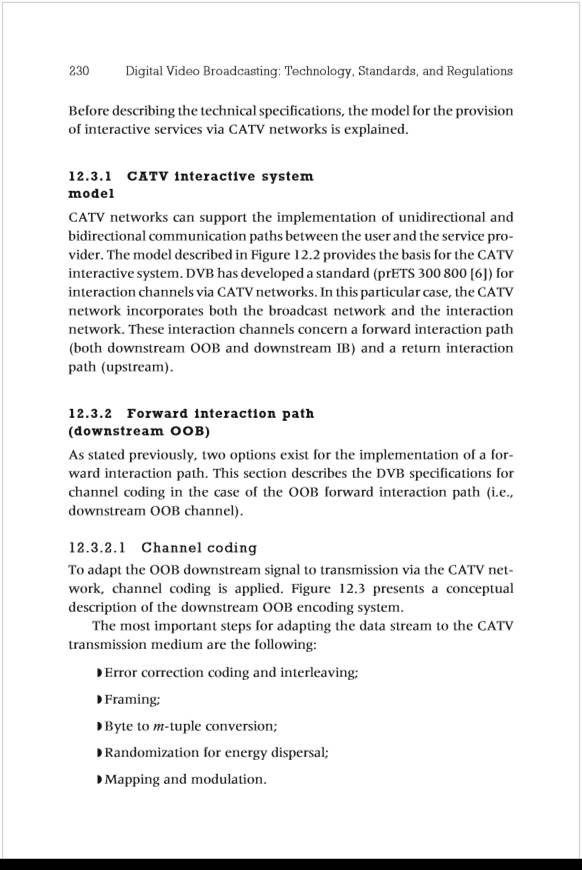

Packetized Elementary Stream (PES) is a specification in the MPEG-2 Part 1 (Systems) (ISO/IEC 13818-1) and ITU-T H.222.0 that defines carrying of elementary streams (usually the output of an audio or video encoder) in packets within MPEG program streams and MPEG transport streams.[3] The elementary stream is packetized by encapsulating sequential data bytes from the elementary stream inside PES packet headers.

A typical method of transmitting elementary stream data from a video or audio encoder is to first create PES packets from the elementary stream data and then to encapsulate these PES packets inside Transport Stream (TS) packets or Program Stream (PS) packets. The TS packets can then be multiplexed and transmitted using broadcasting techniques, such as those used in an ATSC and DVB.

|

Name |

Size |

Description |

|

Packet start code prefix |

3 bytes |

0x000001 |

|

Stream id |

1 byte |

Examples: Audio streams (0xC0-0xDF), Video streams (0xE0-0xEF) [4][5] |

|

|

|

Note: The above 4 bytes is called the 32 bit start code. |

|

PES Packet length |

2 bytes |

Specifies the number of bytes remaining in the packet after this field. Can be zero. If the PES packet length is set to zero, the PES packet can be of any length. A value of zero for the PES packet length can be used only when the PES packet payload is a video elementary stream.[6] |

|

Optional PES header |

variable length (length >= 3) |

not present in case of Padding stream & Private stream 2 (navigation data) |

|

Data |

|

See elementary stream. In the case of private streams the first byte of the payload is the sub-stream number. |

MUX

Sincronico -> PES

DEMUX Sincronico -> Con el PID recupero la informacion

SDI Jitter

Alignment Jitter

![]()

![]()

![]()

![]()

Timing Jitter

PES - PID

PES (Packet Elementary Stream)

- PID Video

- PID Audio -> 1 par AES-EBU

- PID Metadata

- PCR -> Program Ck Reference

PCR (Packet Reception Control)

- Función Demux sincrónico

- Referencia Ck regeneración SDI

- Asocia PID Video

Multiplex y Transporte MPEG-2

- Grupo MPEG (Motion Picture Expert Group)

- Desarrollo 1989 -> 1992

- MPEG2 (H265) -> Protocolo Compresión Video

- MPEG2 -> Protocolo Multiplex/Transporte

- Multiplex sincrónico

- Agregar/Desagregar componentes sin desarmar MPTS

- Incremental (Jerarquico) -> SDH (Syncronous Digital Hierarchy)

MTPS

- ASI → cable coaxil 75 ohms

- IP → UTP clase 6

Se manda el PID de PMT 1 vez por MPTS cada 188 bytes

Se manda el PID de PAT 1 vez c/5seg → trama 90Mbps

Tablas Auxiliares

- CAT - Conditioned Access Table (Encriptado)

- ET - Event Table (Programas especficos)

- NIT - Network Information Table (como es el transporte) → NetID

MPTS

Un flujo de transporte multiprograma (MPTS) es un flujo de transporte UDP (TS) que transporta varios programas. AWS Elemental MediaLive permite crear un MPTS que contenga todos los programas de velocidad de bits variable, una combinación de programas de velocidad de bits variable y constante o todos los programas de velocidad de bits constante.

Para crear un MPTS, debe crear un múltiplex. MediaLive A continuación, agregue hasta 20 MediaLive programas al múltiplex. Por último, se crea un MediaLive canal para cada programa y se asocia cada canal a su programa.

MTPS

- Tx Terrestre

- Tx Alámbrico

- Tx Inalámbrico

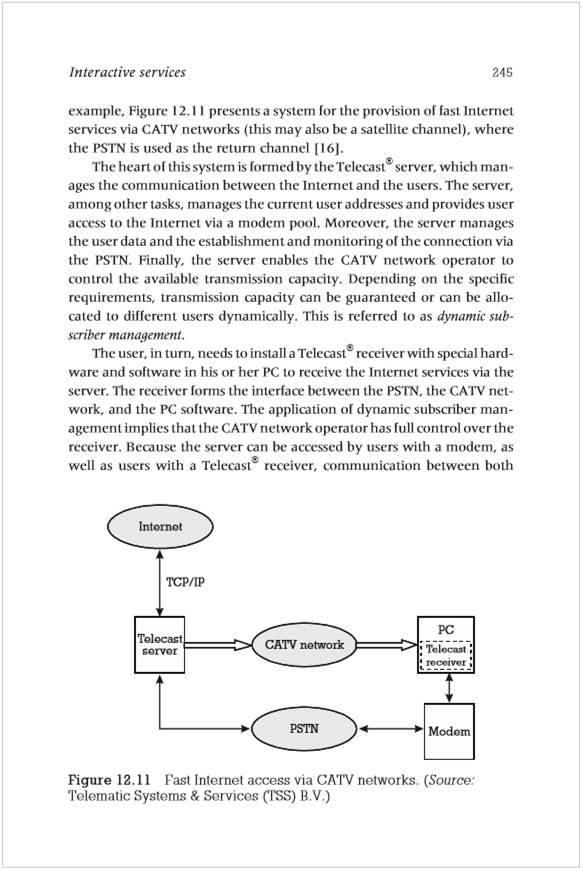

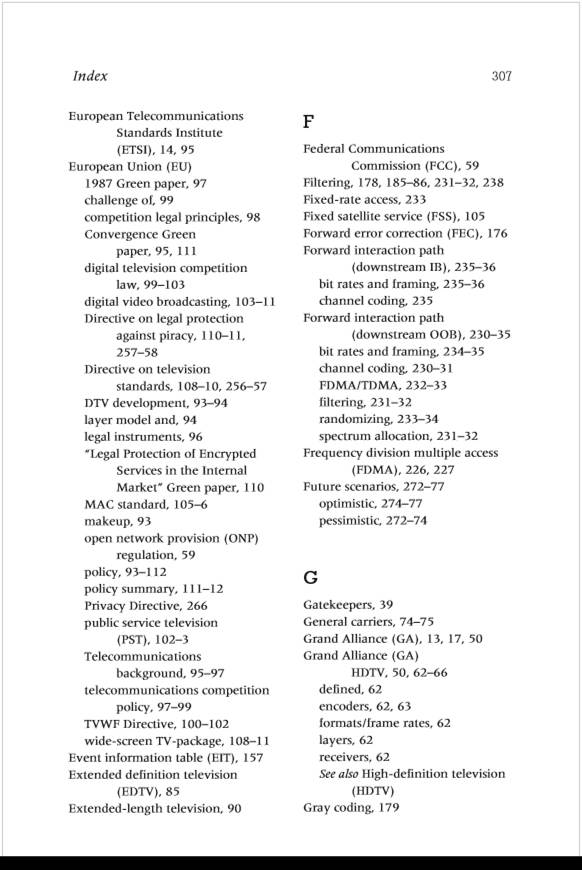

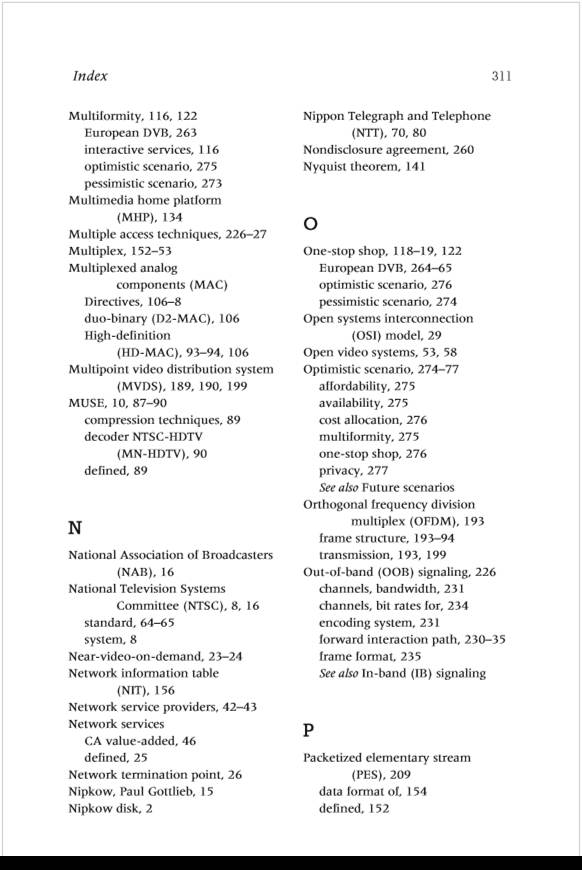

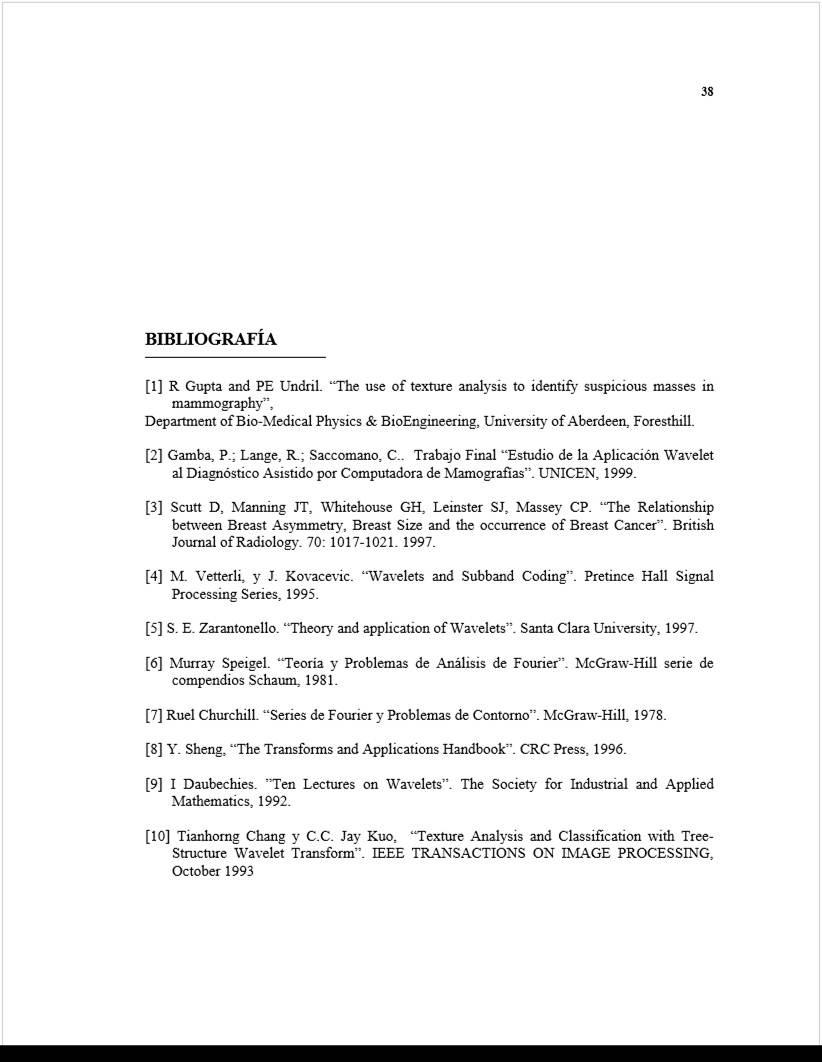

Normas de Transmisión

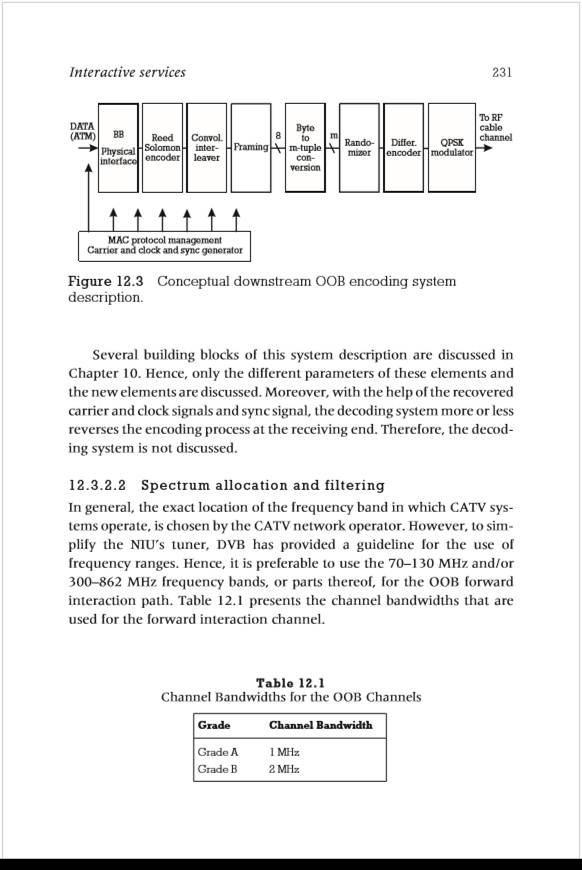

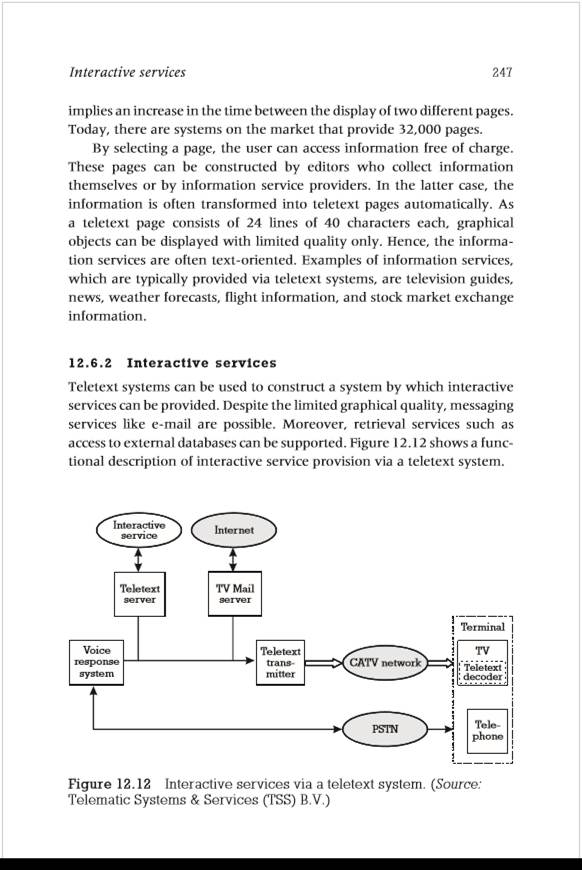

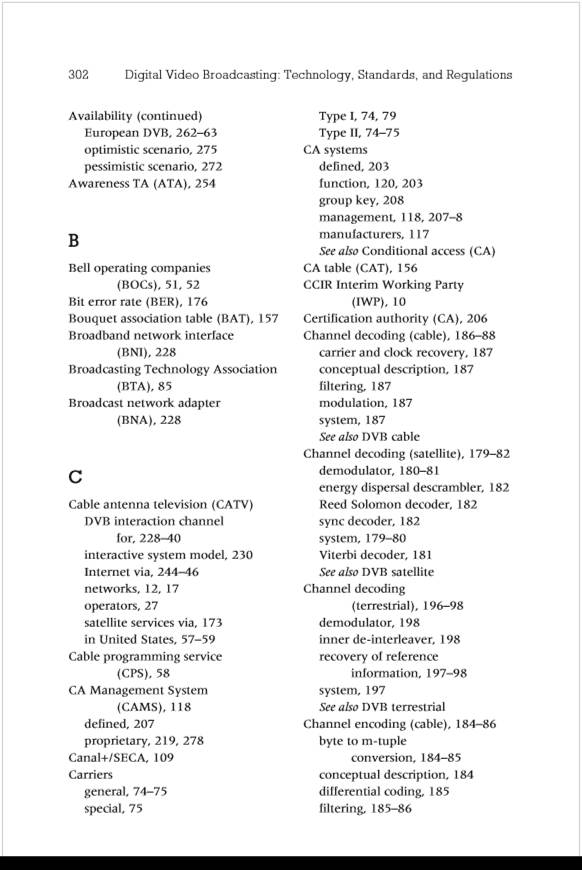

![Estándares para televisión digital [6,7]. La selección de estándares de... | Download Scientific Diagram](3.3.131_Procesamiento_de_Imagenes_y_Video_files/image833.jpg)

Red SFN

A single-frequency network or SFN is a broadcast network where several transmitters simultaneously send the same signal over the same frequency channel.

Analog AM and FM radio broadcast networks as well as digital broadcast networks can operate in this manner. SFNs are not generally compatible with analog television transmission, since the SFN results in ghosting due to echoes of the same signal

Cable -> DVB-C

- QAM

- BW=6MHz -> 42Mbps

- H.264

- HFC (Hybrid Fiber Coaxial)

Satélite -> DVB-s

- PSK

- BW=36MHz -> Hasta 100Mbps

- Acceso FDMA

Streaming

- TV Lineal -> Grilla Programa fija

- TV No lineal -> TV a demanda

- Broadcaster (programadores)

- B2C

- B2B

- B2C -> Director al hogar

- TV Lineal

- B2B -> A traves Opearador TV Paga

- TV Lineal

- TV No lineal

Modelo OSI

- Fisica

- Fibra optica

- SDH

- Inalambrico

- Cableado

- Datalink

- Ethernet

- ATM

- Otros protocolos

- Network

- IPv6

- ATM

- Otros protocolos

- Transporte

- TCP -> ACK

- UDP -> NO ACK

- EUDP -> ACK solo para retransmision

MPTS se monta sobre la capa de transporte

Beneficios

- Ahorro Instalacion

- No aumento BitRate

- Transporto con un solo coaxial

Desventaja

- Tengo que agregar embebedores/des

Single Frequency Network model

Top:Multi Frequency Network

Bottom:Single Frequency Network

Metricas de transmision

Rate TS

Paquetes Perdidos

Paquetes retransmitidos

RTT (Round Trip Time)

- RTT dentro de Argentina -> orden 100mS

- RTT dentro de Sudamerica -> orden 200mS

- Mexico-USA -> 300-400mS

Overhead EUDP -> 20% Rate TS

20% OH + 80% Payload

Rate TS (3 canales) = 24Mbps

OH

Resumen ChatGPT

Restauración y Reconstrucción de Imágenes

Modelo de Ruido Digital: Los modelos de ruido digital representan las variaciones no deseadas en los valores de los píxeles de una imagen. Ejemplos comunes incluyen:

- Ruido Gaussiano: Caracterizado por su distribución normal en torno a un valor medio.

- Ruido de Sal y Pimienta: Píxeles que son drásticamente diferentes de sus vecinos (blancos o negros).

- Ruido Poisson: Común en imágenes con baja iluminación.

Eliminación del Ruido: Las técnicas de eliminación de ruido intentan reducir estos artefactos sin perder detalles importantes de la imagen.

- Filtrado Promedio: Suaviza la imagen promediando los valores de los píxeles vecinos.

- Filtrado Mediano: Reemplaza cada píxel con la mediana de los valores de sus vecinos, útil contra ruido de sal y pimienta.

- Filtrado Gaussiano: Aplica una función de Gauss para suavizar la imagen, preservando mejor los bordes.

Jitter: Variaciones en el tiempo de llegada de los paquetes de datos. En sistemas de video en tiempo real, el jitter puede causar problemas de sincronización entre audio y video, así como pausas o saltos en la reproducción. Para mitigarlo, se utilizan técnicas como:

- Buffering: Almacenar temporalmente los datos entrantes para suavizar las variaciones.

- Algoritmos de sincronización: Ajustar dinámicamente los tiempos de reproducción basándose en la variación del jitter.

Filtrado Inverso y Reconstrucción por Filtrado

Filtrado Inverso: Utilizado para revertir el desenfoque o la distorsión en las imágenes. Si se conoce la función que causó el desenfoque, el filtrado inverso intenta aplicar la inversa de esa función para recuperar la imagen original. Sin embargo, es muy sensible al ruido.

Reconstrucción por Filtrado: Técnicas avanzadas que pueden incluir:

- Filtrado de Wiener: Un método de filtrado óptimo que reduce el ruido y la distorsión simultáneamente.

- Deconvolución Ciega: Utilizada cuando la función de desenfoque es desconocida, estimando tanto la imagen original como la función de desenfoque.

Normas de Compresión JPEG, H.262, H.264, y H.265

JPEG: Utiliza la Transformada de Coseno Discreta (DCT) para convertir bloques de píxeles en frecuencias, permitiendo la compresión mediante la reducción de detalles en frecuencias menos perceptibles por el ojo humano. Es muy efectivo para imágenes fijas.

H.262 (MPEG-2 Video): Utilizado para la compresión de video digital en discos DVD y transmisión televisiva. Soporta video entrelazado y progresivo, y proporciona una buena calidad a tasas de bits relativamente altas.

H.264 (AVC): Ofrece una compresión más eficiente que H.262, soportando resoluciones desde baja definición hasta 4K y más allá. Utiliza técnicas como predicción intra-cuadro e inter-cuadro, y compensación de movimiento.

H.265 (HEVC): Mejora aún más la eficiencia de compresión sobre H.264, permitiendo la transmisión de video de alta calidad a tasas de bits más bajas. Es crucial para la transmisión de video en 4K y 8K.

Procesamiento de Audio

Digitalización: Conversión de señales de audio analógicas a digitales mediante:

- Muestreo: Captura de la amplitud de la señal a intervalos regulares (frecuencia de muestreo).

- Cuantificación: Redondeo de los valores muestreados a los niveles más cercanos en una escala discreta.

Encapsulado AES/EBU: Un estándar para la transmisión de audio digital en aplicaciones profesionales, que incluye características para sincronización y manejo de errores.

Embebido del Audio Digital: Integración del audio digital en flujos de video o en otros formatos de transmisión, manteniendo la sincronización. Ejemplos incluyen:

- SDI (Serial Digital Interface): Permite la transmisión de video y audio integrados sobre un único cable coaxial.

- HDMI (High-Definition Multimedia Interface): Transmite video y audio de alta definición en un solo cable.

Modelos de Compresión de Audio y Normas

Normas MPEG:

- MPEG-1 Layer III (MP3): Formato de compresión de audio que reduce el tamaño del archivo manteniendo una calidad aceptable.

- MPEG-4 AAC (Advanced Audio Coding): Ofrece mejor calidad que MP3 a tasas de bits similares o menores.

Normas Dolby:

- Dolby Digital (AC-3): Utilizado en DVDs, televisión digital y sistemas de cine en casa para sonido envolvente.

- Dolby Atmos: Proporciona una experiencia de audio inmersiva al agregar altura al sonido envolvente tradicional.

Normas AAC:

- Advanced Audio Coding: Utiliza técnicas avanzadas de compresión para ofrecer una mejor calidad de sonido a menores tasas de bits comparado con MP3.

Métodos de Multiplex y Transporte

Norma ATSC: Utilizado en América del Norte para la transmisión digital de televisión. Incluye soporte para HDTV y servicios interactivos.

Norma DVB: Un conjunto de estándares europeos para la transmisión digital de televisión y servicios multimedia, incluyendo DVB-T (terrestre), DVB-S (satélite), y DVB-C (cable).

Norma ISDB: Utilizada en Japón y otros países, soporta transmisión digital de televisión y radio, incluyendo ISDB-T para televisión terrestre.

Encapsulado sobre ATM, SDH, IP:

- ATM (Asynchronous Transfer Mode): Protocolo de transmisión que segmenta los datos en pequeñas celdas fijas, proporcionando baja latencia y QoS.

- SDH (Synchronous Digital Hierarchy): Protocolo de transmisión para redes de telecomunicaciones que proporciona una sincronización precisa y alto ancho de banda.

- IP (Internet Protocol): Protocolo estándar para el envío de datos sobre redes de paquetes, incluyendo video y audio digital.

Imágenes 3D y Efectos de Imágenes

Imágenes 3D: Creación de imágenes con percepción de profundidad, utilizadas en cine, televisión, y realidad virtual. Las técnicas incluyen estereoscopía, renderizado en 3D, y modelado tridimensional.

Efectos de Imágenes: Técnicas para agregar efectos visuales a imágenes y videos, como CGI (Computer-Generated Imagery), compositing, y post-producción.

Procesamiento de Gráfica Estática y Dinámica: Manipulación y mejora de imágenes fijas y en movimiento mediante técnicas de filtrado, transformación, y animación.

Armado de la Imagen: Ensamblaje de imágenes compuestas a partir de múltiples fuentes o capas, como en la edición de video y fotografía.

Subtitulado Electrónico: Inclusión de texto en imágenes de video para traducción, transcripción, o información adicional. Puede ser incrustado en la imagen o transmitido como un flujo de datos separado.

Televisión Multiplataforma

Sistemas de Distribución vía Internet: Plataformas de transmisión de video por internet como IPTV (Internet Protocol Television), OTT (Over-the-Top), y servicios de streaming (Netflix, YouTube).

Almacenamiento y Procesamiento "In The Cloud": Uso de servicios en la nube para almacenar, procesar, y distribuir contenido multimedia, mejorando la accesibilidad y escalabilidad. Ejemplos incluyen Amazon Web Services (AWS), Google Cloud, y Microsoft Azure.

Protocolos de Transporte sobre IP

TCP (Transmission Control Protocol): Protocolo orientado a conexión que garantiza la entrega fiable y ordenada de datos.

UDP (User Datagram Protocol): Protocolo sin conexión que permite la transmisión rápida de datos, pero sin garantías de entrega ordenada o fiabilidad.

EUDP (Enhanced UDP): Variante de UDP con mejoras para aplicaciones específicas, como la transmisión de multimedia en tiempo real.

Aplicaciones sobre HTTP:

- RTMP (Real-Time Messaging Protocol): Utilizado para la transmisión en tiempo real de audio, video y datos entre servidores y clientes.

- HLS (HTTP Live Streaming): Protocolo de transmisión adaptativa desarrollado por Apple que permite la transmisión de video en segmentos pequeños sobre HTTP.

- MPEG-DASH (Dynamic Adaptive Streaming over HTTP): Estándar abierto para la transmisión adaptativa de video que ajusta la calidad del video en tiempo real según las condiciones de la red.

Estos conceptos abarcan una amplia gama de tecnologías y métodos utilizados en el procesamiento de imagen y video, asegurando la calidad, eficiencia y sincronización en diversas aplicaciones multimedia.